📜 要約

### 主題と目的

この調査の主題は、**Remotion × LLM(ChatGPT等)× 音声AI(TTS)× TypeScript を組み合わせて、YouTube向け動画を自動生成する実装例となるGitHubリポジトリを「できる限り網羅的に洗い出し、比較評価すること」**です。

ユーザーの目的は、単なるサンプルコードの発見ではなく、

- Remotion を使って TypeScript/TSX で動画コンポジションを組み立て、

- LLM でスクリプトを生成し、

- 音声AIでナレーションを合成し、

- 最終的に YouTube/Shorts 向けに出力できる、

という**一連のパイプラインを設計・実装する際の「最適な出発点」となる OSS 群を把握すること**にあります。

したがって本レポートでは、

1. その要件に近い有力リポジトリを抽出し、技術スタック・機能・導入しやすさの観点から整理する

2. 単体で「全部入り」のOSSがない現状を踏まえ、**どう組み合わせれば理想のスタックになるか**をアーキテクチャとして提案する

3. さらに、GitHub Topics や検索クエリを使って「今後も継続的に候補を発掘するための方法」まで含めてまとめる

ことを目的とします。

---

### 回答

#### 1. 全体像:条件を完全に満たす「決定版」はまだないが、部品は揃っている

調査の結論として、**Remotion・LLM・音声AI・TypeScript・YouTube自動生成をすべて1つのOSSで完結させた「決定版」リポジトリは、2025年11月時点では見当たりません。**

しかし、パイプラインを以下のレイヤーに分けると、それぞれを高い完成度でカバーするOSSが複数存在します。

1. LLM層:スクリプトや構成JSONを生成する

2. 音声・メディア層:TTSと画像/BGMの取得・生成

3. 動画合成層(TypeScript):Remotionを使ったコンポジションとレンダリング

4. 配信層:YouTube/Shorts向けアップロード

これらを組み合わせれば、ユーザーの求める「Remotion × LLM × 音声AI × TypeScript による YouTube 自動動画生成スタック」は、十分現実的に構築可能です。

以下では、特に重要な OSS を4系統に分けて解説します。

---

#### 2. 中心となる4つの有力OSSとその役割

##### 2-1. ChatGPT Video Generator(chatgptvideoai)

Remotion × OpenAI × TTS をシンプルに統合した最有力サンプル

- リポジトリ: [https://github.com/SaiTech01/chatgptvideoai](https://github.com/SaiTech01/chatgptvideoai)[19](https://github.com/SaiTech01/chatgptvideoai)

- 概要

- 「テキストを入力すると、LLMで要約し、TTSでナレーションを作り、Remotion+FFmpegで動画を生成してダウンロードできる」ChatGPT Video Generatorです[19](https://github.com/SaiTech01/chatgptvideoai)。

- 技術スタックは OpenAI API・Node.js・React・FFmpeg・Remotion で構成され、UIは `.tsx` ベースの React コンポーネントです[19](https://github.com/SaiTech01/chatgptvideoai)。

- ユーザー要件とのフィット

- Remotion を使った TypeScript/TSX の動画コンポーネント

- OpenAI LLM を使ったスクリプト/要約生成

- Node.js ベースの TTS を組み込み、音声付き動画を出力

- 生成動画をブラウザからダウンロード可能

→ **「Remotion × LLM × TTS」がひとつのコードベースにまとまった、もっとも要件に近い統合サンプル**です。

- 導入のしやすさ

- セットアップは、クローン → `npm install` → `src/chat.tsx` に OpenAI API キーを記述 → `npm run start` というシンプルな流れです[19](https://github.com/SaiTech01/chatgptvideoai)。

- 余計な外部依存が少なく、「まず1本AI動画を動かす」には最短ルートと言えます。

- 制約・弱み

- アニメーションは現状シンプルで、「トピック要約1本」向けの構成であると明記されています[19](https://github.com/SaiTech01/chatgptvideoai)。

- HD動画や高度な表現には Remotion CLI を追加で使う必要があります[19](https://github.com/SaiTech01/chatgptvideoai)。

→ 学習・PoCには最適だが、本格的なチャンネル運営には Remotion 側の拡張が前提になります。

**どう活かすべきか**

Remotion+LLM+TTS の「結線の仕方」を掴む最初の教材として利用し、

- OpenAI 呼び出し部分(`src/chat.tsx`)のプロンプトや出力スキーマ

- Remotion コンポーネントと音声ファイルの同期

を読み解いて、自分の用途向けにプロンプトとコンポーネントを差し替える出発点にするのがよいです。

---

##### 2-2. podcast-to-video-remotion

音声+字幕をRemotionで「見せる」ためのTypeScriptテンプレート

- リポジトリ: [https://github.com/harshitsinghai77/podcast-to-video-remotion](https://github.com/harshitsinghai77/podcast-to-video-remotion)[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)

- 概要

- ポッドキャストなどの音声とカバー画像、字幕を組み合わせて「オーディオグラム」動画を作るRemotionテンプレートです[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

- コンポジションは `src/Video.tsx` と `src/Composition.tsx` にまとまっており、ここを編集してサイズや尺、レイアウトを調整します[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

- 強み

- **Remotion × TypeScript で、音声+字幕をタイムラインに載せる「完成形のUI実装」が手に入る**点が最大の価値です。

- 字幕は単語レベル(word-level)のタイムスタンプ付きを前提としており、Subs AI や Otter.ai などで生成した字幕を用いることが推奨されています[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

→ AIで生成したトランスクリプトを使い、「単語ごとにポップする字幕」などYouTubeショート的な表現をRemotionで作り込むのに最適です。

- 弱み

- LLM や TTS のコードは内包しておらず、「音声・字幕は別ツールで用意して持ち込む」前提です[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

**どう活かすべきか**

ChatGPT Video Generator や AutoShorts などで生成した「音声ファイル+字幕JSON」を、

このテンプレートの `src/assets` に流し込む構成をとれば、

- 「AI層(LLM・TTS)」と

- 「動画合成層(Remotion)」

をきれいに分離できます。

**AIの賢さと、動画の見栄えを分けてチューニングできる構成**を目指すなら、このテンプレは非常に相性が良いです。

---

##### 2-3. AutoShorts(auto-shorts)

LLM+TTS+画像APIでショート動画を量産するNode.js/TSパッケージ

- リポジトリ: [https://github.com/alamshafil/auto-shorts](https://github.com/alamshafil/auto-shorts)[11](https://github.com/alamshafil/auto-shorts)

- 概要

- プロンプトからニュースショート、クイズ、ランキング、テキストメッセージ系のショート動画を自動生成するツールです[8](https://github.com/alamshafil/auto-shorts)。

- LLMは OpenAI GPT-4o mini・Google Gemini・Anthropic Claude・ローカルの Ollama Llama3.2 などをサポートし[16](https://github.com/alamshafil/auto-shorts)、

TTSは ElevenLabs / Neets.ai / ローカルTTS、画像は Pexels などを切り替えられます[16](https://github.com/alamshafil/auto-shorts)。

- 代表的なCLI例

```bash

npx auto-shorts -p "make a news short about TypeScript" \

--aiType OpenAIGen \

--ttsType ElevenLabs \

--imageType Pexels \

--elevenLabsAPIKey ... \

--pexelsAPIKey ... \

--openaiAPIKey ...

```

これで「TypeScript ニュースショート」が一発生成されます[8](https://github.com/alamshafil/auto-shorts)。

- 強み

- **LLM・TTS・画像ソースをすべて抽象化した「AIワークフロー層」の設計が非常に参考になる**点です。

- JS/TS API も提供しており、`genVideoWithAI` や `genVideoWithJson` に「動画構成JSON」を渡す方式で拡張できます[18](https://github.com/alamshafil/auto-shorts)。

- 弱み

- 動画レンダリングに使っているのは ffcreator 系であり、Remotion ではありません[16](https://github.com/alamshafil/auto-shorts)。

- 作者自身が「学習目的のプロジェクトであり、開発は停止/プロダクション用途は非推奨」と明記しています[26](https://github.com/alamshafil/auto-shorts)。

**どう活かすべきか**

- **AIワークフローの設計(LLM・TTS・画像APIの抽象化)を学ぶ教材**として使い、

- 動画レンダリング部だけを自作の Remotion コンポジションに差し替えるのが現実的です。

たとえば、

- AutoShorts の `VideoDataType` のような JSON スキーマを自分のサービス側に採用し、

- その JSON を Remotion コンポーネントに渡して `<Composition>` を組み立てる、

といった橋渡しを TypeScript で行う構成が考えられます。

---

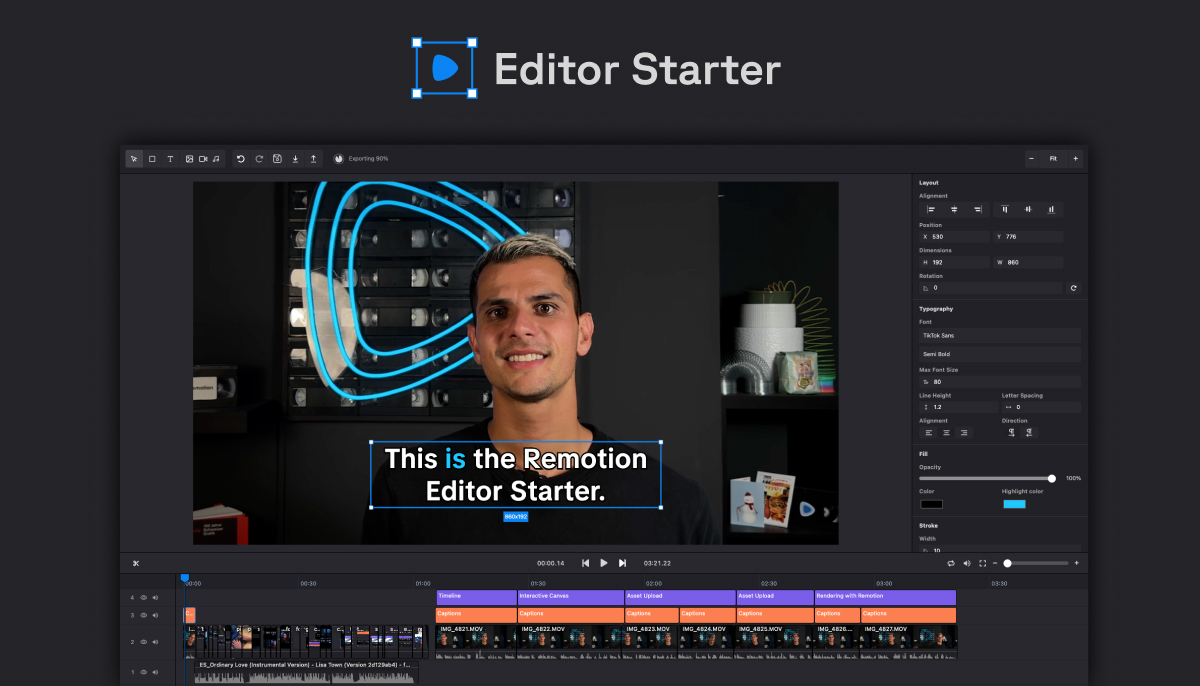

##### 2-4. Remotion Editor Starter(Remotion公式有償スターター)

編集UI・タイムライン・字幕まで揃ったプロダクト基盤

- ドキュメント: [https://www.remotion.dev/docs/editor-starter](https://www.remotion.dev/docs/editor-starter)[2](https://www.remotion.dev/docs/editor-starter)

- 概要

- タイムライン、インタラクティブキャンバス、字幕機能、アセット管理、レンダリングキュー、バックエンドルートなどを備えた「動画編集アプリ用スターター」です[2](https://www.remotion.dev/docs/editor-starter)。

- 80以上の feature flag により機能のオン/オフを制御でき、TypeScriptで構築されています[2](https://www.remotion.dev/docs/editor-starter)。

- 強み

- LLM で生成したシーン構成JSONを Tracks/Items に自動配置し、TTSで生成した音声ファイルを Assets として乗せ、字幕を Captioning 機能に流し込む、という**フル機能のAI動画エディタ基盤**になり得ます。

- Webサービスや社内向けツールとして提供する場合の「骨格」部分をほぼ提供してくれる点は大きいです。

- 弱み

- 有償テンプレートであり、ライセンス条件の確認が必須です[2](https://www.remotion.dev/docs/editor-starter)。

- ある程度の規模感のプロダクトを作る前提(PoCにはオーバースペックになりがち)。

**どう活かすべきか**

- 中長期的に「AI動画編集SaaS」や社内用自動動画生成ツールとして提供するなら、

- Editor Starter をベースに

- LLM・TTS・字幕生成をバックエンドの API として統合していく

という構成がかなり有力です。

最初のPoCフェーズでは ChatGPT Video Generator や podcast-to-video-remotion を使い、

**スケールさせたくなった段階で Editor Starter に移植する**、という2段階戦略が現実的です。

---

#### 3. 理想的なアーキテクチャ像(3層モデル)

上記OSSを踏まえ、「Remotion × LLM × 音声AI × TypeScript × YouTube」を実現する理想構成を3層で整理します。

##### 3-1. 概念アーキテクチャ

```mermaid

flowchart LR

subgraph LLM層

A["台本生成 LLM<br/>OpenAI / Gemini / Claude / Ollama"]

end

subgraph 音声・メディア層

B["TTSエンジン<br/>ElevenLabs / Neets.ai / Local TTS"]

C["画像・BGM取得/生成<br/>Pexels / 画像生成AI"]

end

subgraph 動画合成層(TypeScript)

D["シーン構成JSON生成ロジック<br/>(TSサービス層)"]

E["Remotionコンポジション<br/>(TSX)"]

F["レンダリング & エンコード<br/>Remotion CLI / FFmpeg"]

end

subgraph 配信層

G["YouTube Data API / Shorts"]

end

A --> D

D --> B

D --> C

B --> E

C --> E

E --> F --> G

```

このモデルに先ほどのOSSを重ねると、以下のような整理になります。

- LLM層・音声層・画像層

- AutoShorts が LLM・TTS・画像APIを柔軟に切り替える層として非常に完成度が高い[16](https://github.com/alamshafil/auto-shorts)。

- ChatGPT Video Generator は OpenAI+TTSの最小構成として分かりやすい[19](https://github.com/SaiTech01/chatgptvideoai)。

- 動画合成層(Remotion+TypeScript)

- podcast-to-video-remotion が「音声+字幕」をRemotionで見せるテンプレートとして優秀[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

- Editor Starter がフル機能の編集UI・タイムライン基盤を提供[2](https://www.remotion.dev/docs/editor-starter)。

- 配信層

- 直接YouTubeアップロードまで含むOSSは少ないものの、Remotionでmp4出力後、Node.jsからYouTube Data APIを呼ぶのが一般的パターンになります。

**重要なポイント**は、「Remotion自身にLLM/TTSのロジックを埋め込まない」ことです。

AutoShorts や ChatGPT Video Generator の設計にならい、

- AIワークフロー(LLM/TTS/画像)はTypeScriptのサービス層として実装し、

- Remotionはあくまで「型付きJSONや音声・字幕ファイルを受け取るレンダラ/エディタ」として扱う、

という構成にすると拡張しやすくなります。

---

#### 4. 実際の構築ステップ:何から手を付けるべきか

要件に沿ってPoC〜プロダクションまでを通すための、現実的なロードマップを提案します。

##### ステップ1:ChatGPT Video Generatorで「最小構成の流れ」を把握

1. `chatgptvideoai` をクローンし、OpenAI APIキーを `src/chat.tsx` に設定して動かします[19](https://github.com/SaiTech01/chatgptvideoai)。

2. テキスト入力 → LLM応答 → TTS → Remotionレンダリング → ダウンロード までを一度実際に通します。

3. コード上では

- OpenAI呼び出し部分(プロンプトとレスポンス処理)

- TTSで生成した音声ファイルの管理

- Remotionコンポーネントへのデータ受け渡し

を重点的に読み解きます。

これで、「TypeScript/TSXでLLM+TTS+Remotionをひとつのワークフローにまとめる感覚」を掴めます。

##### ステップ2:podcast-to-video-remotionで映像テンプレを磨く

1. `podcast-to-video-remotion` をセットアップし、手元の音声・字幕ファイルを使って動画をレンダリングします[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

2. `src/Video.tsx` で解像度・フレームレート・尺を YouTube / Shorts に合わせてチューニングします。

3. 生成されたAI音声(ステップ1やAutoShorts側で作成)と字幕JSONを `src/assets` に差し込む小さなスクリプトを書き、

- 「AI層(音声/字幕生成)」

- 「Remotion層(見せ方)」

を分離します。

##### ステップ3:AutoShorts的なAIワークフロー層をTypeScriptで設計

1. AutoShorts の `genVideoWithAI` / `genVideoWithJson` 周辺の実装と、`VideoDataType` 的なJSONスキーマを読み込みます[18](https://github.com/alamshafil/auto-shorts)。

2. 自分の用途(ニュース解説、チュートリアル、クイズ等)に合わせて、

- シーンの並び

- 各シーンのテキスト

- 対応する音声ファイルパス

- 背景画像パス

などを表現する独自の TypeScript 型(例: `VideoSpec`)を定義します。

3. LLM(OpenAI/Gemini/Ollama等)には「必ずその型に沿ったJSONを返す」ようプロンプト設計を行い、

**「LLMはJSON設計通りのデータを吐くサービス」として固定**します。

4. TTSクライアント(ElevenLabs / Neets.ai / Local)を `VoiceProvider` インターフェースで抽象化し、将来の差し替えに備えます。

##### ステップ4:本格的なUI・運用を見据えるなら Remotion Editor Starter

1. 将来的に外部ユーザーや社内利用者に「編集画面」を提供したい場合は、Editor Starter の購入を検討します[2](https://www.remotion.dev/docs/editor-starter)。

2. Tracks/Items/Assets/Captioning の仕組みに、

- LLMで生成した `VideoSpec` JSON をインポートしてシーンを自動配置

- TTS音声を Assets として登録

- 自動字幕結果を Captioning に流し込む

という拡張ポイントを追加します。

3. このレベルになると、Remotionは**単なるレンダラではなく「AI動画エディタ」のコアプラットフォーム**になっていきます。

---

#### 5. 「調べ尽くす」ためのGitHub探索戦略

今回の調査から分かったのは、「条件にピッタリなリポジトリが1つある」というよりも、**似た方向を目指すプロジェクトがいくつも散在している**という状況です。

それらを継続的に発掘するための、具体的な探索戦略も整理しておきます。

##### 5-1. まず見るべき Topics ハブ

- remotion トピック:Remotion関連の全OSSを俯瞰する入口[1](https://github.com/topics/remotion)

- video-generation / video-generator / video-maker:テキスト→動画変換エンジン全般のハブ[7](https://github.com/topics/video-generation?l=typescript)[1](https://github.com/topics/video-generator)

- youtube / youtube-shorts / shorts-maker / faceless-video:YouTube/Shorts/顔出し不要動画向けのツール群[3](https://github.com/topics/youtube-shorts)[6](https://github.com/topics/video-generator?o=desc&s=forks)

- model-context-protocol / mcp:MCP を使って LLM と外部ツールをつなぐ最新エコシステム[0](https://github.com/topics/model-context-protocol)[6](https://github.com/topics/video-generation?l=typescript)

これらのページから、

- 主言語がTypeScript

- 説明文に「shorts」「remotion」「ai」「openai」「tts」等を含む

といった条件で絞ると、候補がかなり浮かび上がります。

##### 5-2. 検索クエリで Topics の抜けを補う

Topics だけでは網羅できないため、以下のようなクエリで GitHub 全体検索を行うとよいです。

- `remotion typescript openai tts`

- `remotion "youtube" "shorts" "ai"`

- `remotion "video generator" "chatgpt"`

これにより、タグ付けが甘いが README 内ではきちんと Remotion×LLM×TTS をやっているリポジトリ(ChatGPT Video Generator など)を拾えます[19](https://github.com/SaiTech01/chatgptvideoai)。

##### 5-3. 収集するメタ情報と評価軸

各候補リポジトリについて、次の情報をCSVやMarkdown表にまとめると、比較検討しやすくなります。

- リポジトリ名 / URL

- 主言語(TypeScript / JS / Python…)

- Remotion利用の有無

- 採用している LLM・TTS・画像API

- 対応ターゲット(YouTube / Shorts / TikTok / 汎用)

- スター数 / フォーク数 / 最終更新日

- ライセンス(MIT / GPL / その他)

- READMEの充実度 / デモ動画やスクリーンショットの有無

この上で、

- Remotion × TypeScript かどうか

- LLM/TTSがどこまで組み込まれているか

- 更新が1年以内か

などの基準でスコアリングすると、「いま取り込むべき上位10〜20件」を安定して選べるようになります。

---

### 結果と結論

1. **単体で「Remotion × LLM × 音声AI × TypeScript × YouTube」を完全に満たすOSSは、現時点では存在しない**

ただし、

- Remotion+OpenAI+TTSを統合した ChatGPT Video Generator[19](https://github.com/SaiTech01/chatgptvideoai)

- Remotion+TypeScriptで音声+字幕動画を描画する podcast-to-video-remotion[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)

- LLM+TTS+画像APIでショート動画を量産する AutoShorts[16](https://github.com/alamshafil/auto-shorts)

- フル機能動画エディタ基盤の Remotion Editor Starter[2](https://www.remotion.dev/docs/editor-starter)

という強力な「部品」は揃っています。

2. **現実的な最適解は、「OSSを組み合わせて自分用スタックを組むこと」**

- ChatGPT Video Generator で LLM+TTS+Remotion の最低限の流れを掴み、

- podcast-to-video-remotion で Remotion 側の画面設計と字幕同期を磨き、

- AutoShorts の設計から LLM/TTS/画像APIの抽象化パターンを学び、

- 将来的なサービス化には Remotion Editor Starter を検討する、

というステップが最も筋が良いと考えられます。

3. **アーキテクチャ上の肝は「AIワークフロー層」と「Remotionレンダリング層」の分離**

- LLMは、あらかじめ定義した TypeScript 型(シーン構成JSON)を返すサービスとして固定し、

- TTSや画像APIは抽象インターフェース(VoiceProvider, ImageProvider)で包み、

- Remotionには「音声ファイル+字幕+シーンJSON」を渡してレンダリングさせる、

という分割が、将来の差し替えや拡張を最も楽にします。

4. **「調べ尽くす」ための継続的な探索フレームワークも重要**

- remotion / video-generation / video-maker / youtube-shorts / faceless-video / model-context-protocol などの Topics を定期的にクロールし[1](https://github.com/topics/remotion)[6](https://github.com/topics/video-generation?l=typescript)、

- `remotion typescript openai tts` のようなクエリで新着を検索し、

- スコアリングした比較表を更新していく、

という運用を組めば、新しい有望リポジトリが出てきたときにも即座にキャッチアップできます。

総合すると、**いま探すべきは「完璧な1リポジトリ」ではなく、用途ごとに最適なOSSの設計パターン**です。

このレポートで整理した4系統のリポジトリと3層アーキテクチャ、そして GitHub Topics を起点にした探索方法を使えば、Remotion × LLM × 音声AI × TypeScript による YouTube動画自動生成パイプラインを、かなり高い精度で設計・実装できるはずです。

🔍 詳細

🏷 調査サマリーと理想アーキテクチャの整理

#### 調査サマリーと理想アーキテクチャの整理

ユーザーの要望は、「Remotion × LLM × 音声AI(TTS)× TypeScriptでYouTube向け動画を自動生成できる、参考になるGitHubリポジトリを“調べ尽くす”」ことでした。調査の結論から言うと、現時点でこの要件を一つのOSSで完全に満たす“決定版”は見当たりません。しかし、パイプラインを段階ごとに分解すると、各フェーズを高い完成度でカバーする有力なリポジトリや公式テンプレートが揃っており、それらを組み合わせることで「理想的なアーキテクチャ像」はかなり明確になります。

---

#### 1. いま何がどこまでできているのか:4つの有力OSSの位置づけ

調査で特に有力だったのは次の4系統です。

1. **ChatGPT Video Generator(chatgptvideoai)** – Remotion × OpenAI × TTS × React/TSX

- テキスト入力からAIで要約を生成し、TTSで音声を合成しつつ、RemotionとFFmpegで動画をレンダリングする「ChatGPT Video Generator」を実装したリポジトリです[19](https://github.com/SaiTech01/chatgptvideoai)。

- 技術スタックは OpenAI API・Node.js・React・FFMPEG・Remotion で[19](https://github.com/SaiTech01/chatgptvideoai)、UIは `.tsx` ベースで構築されています。

- 生成された動画はダウンロード可能で、より高品質なHD動画を作る場合は Remotion CLI の利用が推奨されています[19](https://github.com/SaiTech01/chatgptvideoai)。

→ 「LLMでスクリプト生成」「TTS」「Remotionで映像合成」という3要素が一つのコードベースでつながっており、今回の要件に最も近い“統合サンプル”です。

2. **podcast-to-video-remotion** – 音声→動画のRemotionテンプレート

- ポッドキャストや任意の音声から「オーディオグラム」動画を作るためのテンプレートで、音声・カバー画像・字幕を組み合わせてクリップ動画を生成します[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

- サイズや長さの調整は `src/Video.tsx`、コンポジション定義は `src/Composition.tsx` を編集する構造で[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)、TypeScript+RemotionでYouTube/ショート向けレイアウトを作る“お手本”と言えます。

- 一方で、字幕や音声は外部ツール(Descript、Otter.ai、SubsAIなど)で準備したものを読み込む前提であり[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)、LLMやTTSを内包してはいません。

→ 「音声と字幕を受け取って絵にするRemotion側の枠組み」として、LLM/TTSパートの“受け皿”に最適です。

3. **AutoShorts** – LLM+TTSでショート動画を量産するNode.jsパッケージ

- YouTube Shorts や TikTok 向けの短尺動画を、LLMが書いたスクリプトとTTSで自動生成するパッケージで[11](https://github.com/alamshafil/auto-shorts)、CLIとJS APIの両方を提供します[18](https://github.com/alamshafil/auto-shorts)。

- スクリプト生成は OpenAI GPT-4o やGoogle Gemini、Anthropic Claude、ローカルのOllama LLMなどを選択でき[16](https://github.com/alamshafil/auto-shorts)、音声は ElevenLabs・Neets.ai・ローカルTTSから選べます[16](https://github.com/alamshafil/auto-shorts)。

- コマンド一発で「TypeScriptについてのニュースショートを作る」といった動画を生成できる例がREADMEに示されており[8](https://github.com/alamshafil/auto-shorts)、テキストメッセージ動画・ニュース動画・クイズ動画など複数のテンプレートをサポートします[18](https://github.com/alamshafil/auto-shorts)。

- ただし動画レンダリングには ffcreator など別ライブラリが使われており、Remotionとの統合はありません[16](https://github.com/alamshafil/auto-shorts)。また作者は「学習用プロジェクトで開発は停止中」「プロダクション用途には非推奨」と明記しています[26](https://github.com/alamshafil/auto-shorts)。

→ Remotionとは別系統ですが、「LLMでJSONスキーマを生成し、それをもとにTTS・画像生成・動画合成を組み立てる」アーキテクチャやAPI設計の参考になります。

4. **Remotion Editor Starter(公式有償テンプレート)** – フル機能の動画編集UI基盤

- タイムライン、インタラクティブキャンバス、字幕、アセットアップロード、レンダリング、バックエンドルートなどを備えた「動画編集アプリのスターターキット」です[2](https://www.remotion.dev/docs/editor-starter)。

- 80以上のfeature flagsにより機能のオン・オフや段階的導入が可能で、Tracks/Items/Assets、Captioning、Rendering、Persistence、Backend Routes などの仕組みが整っています[2](https://www.remotion.dev/docs/editor-starter)。

- TypeScriptベースで実装されており、LLMで生成した台本をTracks/Itemsにマッピングし、TTSで生成した音声ファイルをAssetsに取り込んでタイムラインに同期させる、という構成を直接乗せられます[2](https://www.remotion.dev/docs/editor-starter)。

この4つを俯瞰すると、「Remotionを使っているか」「LLM/TTSを内包しているか」「TypeScriptでどこまで書かれているか」が微妙にずれており、単体で“全部入り”なOSSは存在しないことが分かります。一方で、それぞれが得意とするレイヤーがきれいに分かれていることは、**自分の用途に合わせて部品を選び、アーキテクチャとして組み立てる余地が大きい**ことも意味します。

---

#### 2. GitHub Topics から見える「潮流」と空白地帯

GitHub Topics「remotion」には139件以上の公開リポジトリが紐づいており、その中には

- 「モーショングラフィックスとTTSでニュースレターを毎日YouTube動画に変換する完全自動ビデオメーカー」

- 「Model Context Protocol (MCP) とREST APIを用いて、TikTok / Instagram Reels / YouTube Shorts向けのショート動画を自動生成するツール」

といった説明のプロジェクトが含まれていることが確認できます[1](https://github.com/topics/remotion)[7](https://github.com/topics/video-generation?l=typescript)。さらに、`youtube-shorts` や `shorts-maker`、`faceless-video`、`video-generator` などのトピック群にも、

- 長尺動画を GPT-4+FFmpeg+OpenCV で解析し「面白い部分」を切り出すPythonツール[21](https://github.com/topics/video-generation?o=desc&s=forks)

- Redditなどからスクリプトを取得し、動画化してYouTubeへ自動投稿するシステム[21](https://github.com/topics/video-generation?o=desc&s=forks)

といったAI動画ワークフローが多数存在します[3](https://github.com/topics/youtube-shorts)[6](https://github.com/topics/video-generator?o=desc&s=forks)。

しかし、これらのトピック要約からは

- 主要言語がTypeScriptかどうか

- Remotionを使っているかどうか

- どのLLM/TTSをどう統合しているか

までは読み取れず、実際に各リポジトリのREADMEをクロールしないと精査できません[1](https://github.com/topics/remotion)[3](https://github.com/topics/youtube-shorts)。これは、**ニーズにぴったりのOSSが潜在的には存在している可能性がある一方で、カタログ化はまだ“人力の調査”に依存している**ことを示唆しています。

---

#### 3. 理想的なアーキテクチャ:3層モデルで考える

以上を踏まえると、「Remotion × LLM × 音声AI × TypeScript × YouTube動画自動生成」の理想アーキテクチャは、次の3層モデルで整理すると理解しやすくなります。

##### 3.1 概念アーキテクチャの全体像

```mermaid

flowchart LR

subgraph LLM層

A[台本生成 LLM<br/>OpenAI / Gemini / Claude / Ollama]:::llm

end

subgraph 音声・メディア層

B[TTSエンジン<br/>ElevenLabs / Neets.ai / Local TTS]:::audio

C[画像・BGM生成<br/>Pexels / 画像生成AI]:::audio

end

subgraph 動画合成層(TypeScript)

D[シーンJSON生成ロジック<br/>(TS)]:::logic

E[Remotionコンポジション<br/>(TSX)]:::remotion

F[レンダリング & 書き出し<br/>Remotion CLI / FFmpeg]:::remotion

end

subgraph 配信層

G[YouTube API / Shorts]:::deploy

end

A --> D

D --> B

D --> C

B --> E

C --> E

E --> F --> G

classDef llm fill:#f6d5ff,stroke:#b86bff;

classDef audio fill:#ffe6cc,stroke:#ff9900;

classDef logic fill:#e0f7fa,stroke:#00acc1;

classDef remotion fill:#e8eaf6,stroke:#3f51b5;

classDef deploy fill:#e8f5e9,stroke:#43a047;

```

この図に、先ほどのリポジトリ群を重ねてみると、どこを流用し、どこを自作すべきかが見えてきます。

- **LLM層**

- AutoShortsは、OpenAI GPT-4o・Gemini・Claude・Ollama など複数LLMを抽象化した「スクリプト生成レイヤー」を実装しており[16](https://github.com/alamshafil/auto-shorts)、台本生成ロジックやプロンプト設計の参考になります。

- chatgptvideoaiは単一のOpenAI APIキーを前提とした簡潔な実装ですが[19](https://github.com/SaiTech01/chatgptvideoai)、Remotionとの直結という意味で、最短経路のサンプルになっています。

- **音声・メディア層**

- AutoShortsはTTSに ElevenLabs / Neets.ai / ローカルTTS を切り替えられ、Pexelsやスクレーパーから画像を取得します[16](https://github.com/alamshafil/auto-shorts)。

- chatgptvideoaiはNode.jsベースのTTSを組み込み、生成した音声をRemotion動画に重ねて出力します[19](https://github.com/SaiTech01/chatgptvideoai)。

→ つまり、「プロダクションに近い多プロバイダ対応ならAutoShorts設計」「Remotionとの結線方法を学ぶならchatgptvideoai」という棲み分けが見えてきます。

- **動画合成層(TypeScript/Remotion)**

- podcast-to-video-remotionは、音声+字幕からオーディオグラムを作るTSXコンポジションの具体例を提供し[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)、YouTube向けアスペクト比・尺の感覚を掴むのに有用です。

- Editor Starterは、より本格的な編集UIとタイムライン管理、字幕、レンダリングキュー、バックエンドルートなどを備え[2](https://www.remotion.dev/docs/editor-starter)、LLM/TTSを背後に持つ「AI動画エディタ」としての中核になり得ます。

- **配信層(YouTube API)**

- 今回参照したリポジトリには、YouTube Data APIを使った自動アップロード実装は明示的には含まれていませんが、ニュースレターをYouTube動画化するRemotionプロジェクトの説明から、実運用ではYouTube連携が現実的なゴールになっていると読み取れます[1](https://github.com/topics/remotion)。

→ 実装上は、レンダリング完了後のファイルをNode.jsで拾ってYouTube APIにPOSTする比較的標準的なパターンを取ることになると考えられます。

---

#### 4. 実際に何から手をつけるべきか:おすすめロードマップ

ユーザーが「まず動くものを作りたい」のか、「将来自社プロダクトに組み込みたい」のかで最適なスタート地点は変わりますが、調査結果を踏まえると、次のようなステップが現実的です。

##### ステップ1:最小構成のPoCをchatgptvideoaiで掴む

1. `chatgptvideoai` をクローンし、OpenAI APIキーを設定して動かす[19](https://github.com/SaiTech01/chatgptvideoai)。

2. テキスト入力→LLM応答→TTS→Remotionレンダリング→動画ダウンロード まで一連の流れをトレースする。

3. ここで得られるのは、「Remotionで音声とシンプルなアニメーションを同期させるTypeScript/TSXコード」と「LLM/TTSを同一Nodeプロセス内で扱う基本パターン」です[19](https://github.com/SaiTech01/chatgptvideoai)。

##### ステップ2:音声ベース動画テンプレをpodcast-to-video-remotionで磨く

1. `podcast-to-video-remotion` を導入し、`src/Video.tsx` と `src/Composition.tsx` を編集しながら、アスペクト比や尺、字幕のスタイルをYouTube向けに調整する[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

2. 外部で用意した音声・字幕の代わりに、ステップ1のLLM/TTS出力を差し込むスクリプト(ビルド前にassetsを差し替える小さなNodeスクリプトなど)を書く。

3. これにより、「LLM/TTSは外部プロセス、Remotionは純粋なレンダラ」という疎結合な構成を試せます。

##### ステップ3:LLM/TTSワークフローをAutoShorts的に抽象化する

1. AutoShortsのJS API例(`genVideoWithAI` や `genVideoWithJson`)を参考に[17](https://github.com/alamshafil/auto-shorts)、

- プロンプトから台本JSONを生成

- ElevenLabsなどで音声を生成

- Pexels APIで関連画像を取得

といった処理をTypeScriptのサービス層として切り出します[16](https://github.com/alamshafil/auto-shorts)。

2. 動画合成部分だけをRemotionコンポジションに差し替えることで、「AutoShortsのAIパート+Remotionのレンダリングパート」というハイブリッド構成が実現できます。

3. 注意点として、AutoShorts作者は「学習目的で開発停止中」「プロダクション利用には向かない」と明記しているため[26](https://github.com/alamshafil/auto-shorts)、コードはあくまで設計の参考として読むのが安全です。

##### ステップ4:本格的なエディタ/サービス化を目指すならEditor Starter

1. 将来的にユーザー向けのWebサービスや内製ツールとして提供する前提なら、Editor Starterの導入を検討します[2](https://www.remotion.dev/docs/editor-starter)。

2. Tracks/Items/Assets/Captioning/Rendering などの仕組みに、

- LLMで生成したシーン構成JSONをインポートして自動配置

- TTSで生成した音声ファイルをAsset Uploadに登録

- 自動字幕生成結果をCaptioningに流し込む

といった拡張ポイントを実装するイメージです[2](https://www.remotion.dev/docs/editor-starter)。

3. ライセンスは企業規模により条件が異なるため、商用利用前にRemotionのライセンス文書およびEditor Starterの利用規約を確認する必要があります[2](https://www.remotion.dev/docs/editor-starter)。

---

#### 5. 今後のリポジトリ探索をどう“調べ尽くす”か

今回の調査では、「条件に完全一致するプロジェクトを網羅列挙する」には至らず、GitHub Topicsの要約レベルにとどまっています[1](https://github.com/topics/remotion)[21](https://github.com/topics/video-generation?o=desc&s=forks)。より徹底した調査を行うには、次のような自動・半自動プロセスが有効だと考えられます。

- **検索クエリの活用**

- `remotion typescript openai tts site:github.com`

- `remotion "youtube" "shorts" "ai" site:github.com`

といったクエリで候補を広く拾い上げることが推奨されています[0](https://github.com/topics/video-generation?o=desc&s=forks)。

- **フィルタ条件の明確化**

- 言語: TypeScript または `.ts` / `.tsx` が多数

- README/トピックに `remotion`, `youtube`/`shorts`, `openai`/`gpt`/`tts` などを含む

- 最終更新が1年以内、スター数・フォーク数が一定以上

という条件で機械的にスクリーニングする方針が提案されています[0](https://github.com/topics/video-generation?o=desc&s=forks)。

- **取得すべきメタ情報**

- リポジトリ名・URL・主言語・Remotion利用有無・採用LLM/TTS・対象プラットフォーム(YouTube/Shorts/TikTok)・サンプル動画リンク・スター数・最終更新日などを収集し、比較表化するのが望ましいと考えられます[1](https://github.com/topics/remotion)。

この「機械的な候補抽出 → 人手によるトップ10〜20の精読」という二段階を踏めば、現状分かっている4系統に加えて、よりニッチだが優れたプロジェクトも拾い上げられるはずです。

---

#### 6. まとめ:いま選ぶべき“現実解”と将来像

- **単一のOSSで“全部入り”はまだ存在しない**

- ただし

- Remotion + OpenAI + TTS + TSX を一体化した `chatgptvideoai`[19](https://github.com/SaiTech01/chatgptvideoai)

- TypeScript+Remotionで音声クリップを美しく可視化する `podcast-to-video-remotion`[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)

- LLM+TTS+画像生成でショート動画を量産する `AutoShorts`[16](https://github.com/alamshafil/auto-shorts)

- そしてフル機能の編集基盤である Remotion Editor Starter[2](https://www.remotion.dev/docs/editor-starter)

が揃っており、「理想アーキテクチャを構成する部品」はほぼ出揃っています。

- **当面のおすすめ構成**

1. chatgptvideoaiをベースに「LLM+TTS+Remotion」の結線を把握する[19](https://github.com/SaiTech01/chatgptvideoai)。

2. podcast-to-video-remotionのコンポジション設計を参考に、YouTube/Shorts向けの画面設計をTypeScriptで磨く[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

3. AutoShortsの設計から、複数LLM・TTS・画像ソースを切り替え可能な抽象レイヤーを自作し、将来的に差し替えやすい構成にする[16](https://github.com/alamshafil/auto-shorts)。

4. 本格的なサービス化/社内ツール化を視野に入れるなら、Editor Starterのタイムライン・字幕・レンダリング基盤の上に、これらのAIレイヤーを統合していく[2](https://www.remotion.dev/docs/editor-starter)。

言い換えると、現時点での「最適解」は、**一つの完璧なリポジトリを探すことではなく、用途ごとに最適なOSSの設計パターンを引き出し、自分のユースケースに合わせて“Remotion×LLM×音声AIスタック”を組み上げること**だと考えられます。その際、本セクションで整理した3層アーキテクチャと4つの有力OSSは、実装と技術選定の“地図”として役立つはずです。

🖍 考察

### 調査の本質

今回の本質的な問いは、「Remotion × LLM × 音声AI × TypeScriptを使って、YouTube向け動画(特にショート)を自動生成したい。そのために、どんなGitHubリポジトリを“参考実装”として押さえ、どう組み合わせればよいか」です。

ユーザーの表向きの要望は「おすすめのレポジトリを調べ尽くしてまとめてほしい」ですが、その背後には次のような真のニーズが見えます。

- 1つの完璧なOSSを当てるより、「自分のプロダクトに組み込める現実的なアーキテクチャ」と「具体的なスタート地点」が欲しい

- LLM・TTS・Remotionそれぞれの“役割分担”を理解して、将来の差し替えや拡張に耐える設計をしたい

- GitHub上のプロジェクトが玉石混交である中から、「どれをどの観点で参考にすべきか」という判断を省力化したい

したがって、価値のコアは

1. 「全部入りの決定版はない」という現状認識を明確にしつつ、

2. それでも目的達成に必要な要素(LLM層/TTS層/Remotion層/配信層)が、どのOSSでどこまでカバーされているかを整理し、

3. 自分用スタックを組み立てるための“設計図”と“導入ロードマップ”を提示すること

だと言えます。

### 分析と発見事項

まず、調査で浮かび上がった主要OSSを、役割とカバー範囲で整理します。

#### 1. 4系統の核となるOSSの「守備範囲」

表を一度に俯瞰すると、どこに何が足りないかが分かりやすくなります。

表1. 主要リポジトリの位置づけ

| リポジトリ | 役割・特徴 | Remotion | LLM | TTS/音声AI | 主言語 / 実装 | コメント |

|---|---|---|---|---|---|---|

| ChatGPT Video Generator(chatgptvideoai)[19](https://github.com/SaiTech01/chatgptvideoai) | テキスト→OpenAI要約→TTS→簡易アニメーション動画生成 | ○ | OpenAI | ○(Nodeベース) | React + Node(TSXあり) | 「LLM+TTS+Remotion」が1リポジトリで繋がっている最有力サンプル |

| podcast-to-video-remotion[15](https://github.com/harshitsinghai77/podcast-to-video-remotion) | 音声+字幕+カバー画像からオーディオグラム動画 | ○ | 外部前提 | 外部前提 | TypeScript + Remotion | AIは外出し。Remotionでの「音声×字幕×レイアウト」のお手本 |

| AutoShorts[16](https://github.com/alamshafil/auto-shorts) | LLM+TTS+画像でショート動画生成(CLI/JS/UI) | ×(ffcreator系) | OpenAI/Gemini/Claude/Ollama | ElevenLabs/Neets.ai/ローカルTTS | Node/TS | ワークフロー設計と抽象レイヤーが秀逸。Remotionとは別エンジン |

| Remotion Editor Starter[2](https://www.remotion.dev/docs/editor-starter) | Remotion製フル機能動画エディタのスターター | ○ | なし(拡張前提) | なし(拡張前提) | TypeScript | タイムライン、字幕、アセット管理まで揃った「サービス化」の土台 |

ここから分かる重要な事実は二つあります。

1. 「Remotion × LLM × TTS × TypeScript × YouTube自動投稿」を1つで完全に満たすOSSは現状存在しない

2. しかし、レイヤーを分割して見れば、ほぼすべてのパーツは既存OSSでカバーできる

つまり、**「1リポジトリ完結」を諦め、パイプラインを部品に分解して再構成する発想に切り替えること**が、現実解になります。

#### 2. トピックと検索から見えるOSSの“生態系”

GitHub Topicsを俯瞰すると、Remotionやショート動画生成に関するエコシステムが、すでにかなり形成されていることも見えてきます。

- `remotion` トピック:Remotionベースの動画生成テンプレやツールが多数[1](https://github.com/topics/remotion)

- `video-generation`(TypeScript)トピック:MCP+REST APIでTikTok/Instagram Reels/YouTube Shorts向けの短尺動画を生成するプロジェクトが含まれる[6](https://github.com/topics/video-generation?l=typescript)

- `youtube-shorts` / `shorts-maker` / `faceless-video`:ショート形式や顔出し不要の自動生成動画の事例が集積[2](https://github.com/topics/youtube-shorts)[3](https://github.com/topics/video-maker)

- `model-context-protocol`(MCP):LLMから外部ツール(スクレイパー、Figma、Unityなど)を操作するプロトコルの実装群[0](https://github.com/topics/model-context-protocol)

一方で、トピック説明レベルでは

- 言語がTypeScriptかどうか

- Remotionか他のレンダラか

- LLMとTTSをどう統合しているか

までは分からず、READMEと依存関係を精読しない限り真価を判断できません[1](https://github.com/topics/remotion)[3](https://github.com/topics/video-maker)。つまり、「候補はたくさんあるが、カタログ化はまだ人力・半自動が必要」という中途半端な成熟度にあります。

#### 3. アーキテクチャとして整理したときの「3層モデル」

調査結果を抽象化すると、「Remotion × LLM × 音声AI」パイプラインは次の3層に整理できます。

1. LLM・メディア生成層

- 台本生成:OpenAI / Gemini / Claude / Ollama(AutoShortsが好例[16](https://github.com/alamshafil/auto-shorts))

- TTS:ElevenLabs / Neets.ai / ローカルTTSなど[16](https://github.com/alamshafil/auto-shorts)

- 画像・BGM取得:Pexelsや画像生成AI[16](https://github.com/alamshafil/auto-shorts)

2. 動画合成層(TypeScript/Remotion)

- シーンJSONを受け取り、TS/TSXでコンポジションを組む(podcast-to-video-remotionやEditor Starterが参考[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)[2](https://www.remotion.dev/docs/editor-starter))

- レンダリングと書き出しはRemotion CLI/FFmpegなど

3. 配信・オーケストレーション層

- CLI / Web UI / API(AutoShorts的CLIやNext.js UI[18](https://github.com/alamshafil/auto-shorts))

- YouTube Data APIによる自動アップロード

- 今後はMCP経由でLLMエージェントから操作する形も現実的[0](https://github.com/topics/model-context-protocol)[6](https://github.com/topics/video-generation?l=typescript)

この3層に先ほどの4系統のOSSを当てはめると、「どの層が充足されていて、どこを自作すべきか」が見えてきます。

### より深い分析と解釈

ここから、「なぜ今このような分断状態になっているのか」「なぜ単一の決定版が出てこないのか」を、少なくとも3段階で掘り下げてみます。

#### 1. なぜ「全部入りOSS」が存在しないのか

なぜ1本で完結するRemotion×LLM×TTS×YouTube OSSが出てこないのか。要因を分解すると、少なくとも次の3つがあります。

1段階目:技術的複雑さの分散

- LLM、TTS、画像API、動画レンダリング、YouTube API…と、性質の異なる要素が多く、1人・1チームで全部を高品質に作り込むのは負荷が高い。

- 結果として、

- AutoShortsのように「AIワークフロー特化」

- podcast-to-video-remotionのように「Remotionテンプレ特化」

に分かれている。

2段階目:用途ごとの要件のバラつき

- ニュースショート、クイズ動画、ポッドキャストのハイライト、解説動画…など、必要な映像表現や構成がかなり違う。

- AutoShortsは複数テンプレ(ニュース、クイズ、ランキングなど)をサポートしていますが[18](https://github.com/alamshafil/auto-shorts)、それでも全用途をカバーしきれてはいない。

3段階目:商用性とライセンスの問題

- 真に完成度の高い「動画エディタ基盤」は、Remotion Editor Starterのように有償テンプレートとして提供されがち[2](https://www.remotion.dev/docs/editor-starter)。

- OSSだけで「プロダクション級UX+AIワークフロー」を完備したものは、ビジネス的にも生まれにくい。

この3つの要因が重なって、「用途別・レイヤー別に分かれた“良いパーツ”だけが点在している」状態を生んでいます。

#### 2. なぜ「AutoShorts型」の設計が増えているのか

AutoShortsは、Remotionは使っていないものの、現代的な設計パターンをかなり先取りしています[16](https://github.com/alamshafil/auto-shorts)。

- LLM種別を抽象化(OpenAI/Gemini/Claude/Ollamaを`aiType`で切り替え[16](https://github.com/alamshafil/auto-shorts))

- TTS種別を抽象化(ElevenLabs/Neets.ai/ローカルを`ttsType`で切り替え[16](https://github.com/alamshafil/auto-shorts))

- 画像ソースを抽象化(Pexelsやスクレイパーを`imageType`で切り替え[16](https://github.com/alamshafil/auto-shorts))

- CLI・JS API・Web UIを一体として提供[18](https://github.com/alamshafil/auto-shorts)

なぜこのような抽象化が重要か。「なぜ?」を掘ると:

1段階目:ベンダーロックインの回避

- LLMもTTSも価格・性能が激しく変動中で、1〜2年のスパンでベストチョイスが変わる。

- 初期から抽象レイヤーを切っておくと、将来の差し替えコストが大きく下がる。

2段階目:コスト最適化の必要性

- ニュースショートを大量生成するような用途では、1本数円〜数十円の差が積み上がる。

- AutoShortsがOllama(ローカルLLM)をサポートするのは、まさに「GPUさえあれば推論コストを実質0に近づけたい」というモチベーション[16](https://github.com/alamshafil/auto-shorts)。

3段階目:MCPのような標準プロトコルへの接続準備

- MCPトピックに現れたプロジェクト群は、「LLMから外部ツールを標準的に呼び出す」方向に進んでいます[0](https://github.com/topics/model-context-protocol)。

- AutoShortsの`aiType`/`ttsType`は、そのまま「MCPのツール名」とマッピングしやすい構造であり、MCP時代の設計感覚と相性が良い。

したがって、Remotionを使う場合でも、「AutoShorts的な抽象レイヤーを自作しておくかどうか」は、数年スパンで見たときの戦略的な分かれ目になります。

#### 3. なぜ「MCP」が将来重要になるのか

MCP(Model Context Protocol)のプロジェクト群を見ると、LLMがRESTやローカルプログラムを通じてFigma、Unity、スクレイパー(Firecrawl)などを操作する事例が増えています[0](https://github.com/topics/model-context-protocol)。これをRemotion文脈で考えると:

1段階目:LLMエージェントが動画生成パイプラインを直接制御

- 例:「今週の人気記事をスクレイピング→要約→ショート動画台本生成→音声&画像生成→Remotionでレンダリング→YouTubeに投稿」、この一連をLLMエージェントからMCP経由で“指示”できる。

2段階目:Remotionを「MCPツール」として公開

- Remotionベースの動画エンジンを、「動画構成JSON→mp4を吐くツール」としてMCPに登録すれば、他のエージェントやツールからも再利用可能になる。

3段階目:将来の複合エージェントシステムとの親和性

- ニュース収集エージェント、台本エージェント、動画エディタエージェント…というマルチエージェント構成の中で、動画生成部分だけを標準化しておくメリットが大きい。

このように、「今Remotionで閉じた実装を作る」だけでは、2〜3年後のAIエージェント前提の世界でメンテが苦しくなりかねません。**MCPを見据えた設計にしておくこと自体が、将来の保守コストを下げる“保険”**だと解釈できます。

### 戦略的示唆

ここまでの分析を、実際にユーザーが取り得る行動に落とし込みます。

#### 1. いま取るべき技術スタック戦略

1. 「単一決定版探し」をやめて、3層モデルで必要パーツを定義する

- LLM・TTS・画像生成/取得はAutoShortsの設計を参考に「AI層」として独立させる[16](https://github.com/alamshafil/auto-shorts)。

- Remotionは「テンプレ+レンダリングエンジン」として純化する(podcast-to-video-remotionやEditor Starterをベースに[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)[2](https://www.remotion.dev/docs/editor-starter))。

- 配信はYouTube API連携スクリプトとして別モジュールに置く。

2. Remotion側は「AI非依存の美しいテンプレ」を先に完成させる

- まずは手書きのスクリプト+手元の音声ファイルで、Remotionコンポジション(ショート向け9:16含む)を磨く。

- これにより、あとからLLM/TTSを差し替えても、「見た目の品質」は維持される。

3. AI層はAutoShorts的な抽象レイヤー設計を自前のTypeScriptで再現

- `AIProvider` / `TTSProvider` / `ImageProvider`インターフェースを定義して、実装クラスを切り替える。

- 当初はOpenAI+ElevenLabs+Pexelsのような1セットに固定してよく、将来必要になったらGemini/OllamaやNeets.aiに差し替える。

4. MCPはすぐ導入しなくても、「入れ替え可能な境界」を意識して設計する

- すべての外部API呼び出しを1〜2個のサービス層に集約し、のちにMCPサーバに移行できるようにしておく。

#### 2. 実装フェーズごとの「現実的ロードマップ」

ユーザーが0→1→10と進める時系列を意識して、段階的なアクションプランをまとめます。

フェーズA:PoC(数日〜1週間)

1. ChatGPT Video Generatorを動かして、LLM+TTS+Remotionの一連の流れを体験する[19](https://github.com/SaiTech01/chatgptvideoai)。

2. プロンプトを自分の想定チャンネル(ニュース解説、Tips、雑学など)向けに少し書き換え、どの程度使えるか感覚を掴む。

フェーズB:テンプレとAI層を分離する(2〜4週間)

1. podcast-to-video-remotionを導入し、YouTube向けの解像度・レイアウトにRemotionコンポジションを調整する[15](https://github.com/harshitsinghai77/podcast-to-video-remotion)。

2. LLM+TTSで生成した音声ファイルと字幕JSONを、`src/assets`に差し込むスクリプトをTypeScriptで作る。

3. ここでは、AI側はシンプルにOpenAI+ElevenLabsなど1セットでよい。

フェーズC:AutoShorts型の抽象レイヤーを導入(1〜2ヶ月)

1. AutoShortsの`genVideoWithAI` / `genVideoWithJson`周りのコードとJSONスキーマを読み、同等の`VideoSpec`を自プロジェクトに定義する[18](https://github.com/alamshafil/auto-shorts)。

2. ニュース/クイズ/ランキングなど、よく使いそうなテンプレだけを自分の`VideoSpec`に落とす。

3. `VideoSpec`→Remotionコンポジション変換ロジックを実装し、AutoShorts的な「テンプレの切り替え」をRemotion上で再現する。

フェーズD:サービス化とUX強化(中期)

1. Remotion Editor Starterの導入を検討し、タイムライン・キャプション・アセット管理UIを自動生成エンジンの上に被せる[2](https://www.remotion.dev/docs/editor-starter)。

2. ユーザーがAI生成した動画を細かく修正できるUIを用意し、「半自動+編集」でクオリティを底上げする。

3. YouTube API連携やスケジューラを加えて、「毎朝7時にニュースショートを自動投稿」などのワークフローを構築する。

### 今後の調査

最後に、今回の分析を一過性で終わらせず、継続的に質を高めていくための追加調査テーマを整理します。

#### 1. 追加で深掘りすべきテーマ例

- RemotionテンプレートとAutoShorts形式JSONの“共通スキーマ”設計

- LLM出力を安全にJSON(VideoSpec)へマッピングするためのプロンプト設計・バリデーション手法

- ElevenLabs / Neets.ai / ローカルTTSの音質・コスト・レイテンシ比較と、用途別の最適組み合わせ

- 長尺動画→ショート自動切り出しツール(Python系GPT-4+FFmpeg+OpenCVなど[2](https://github.com/topics/youtube-shorts))とRemotionパイプラインの連携可能性

- MCP対応のTypeScript実装を用いた、「LLMエージェントからRemotionレンダリングを指示する」プロトタイプ設計

- Remotion Editor Starterのライセンス・料金体系と、商用サービスへの統合パターン[2](https://www.remotion.dev/docs/editor-starter)

- YouTube Data APIを用いた大量自動投稿時のレート制限・ポリシー・BANリスクと対策

- OSSベースのパイプラインにおける著作権・利用規約(特に画像・音声素材API)上のリスク整理

#### 2. 継続モニタリングの観点

- `remotion` / `video-generation`(TypeScript)/ `shorts-maker` / `faceless-video` / `model-context-protocol` トピックに新規追加されるリポジトリ

- AutoShorts以降に出てくるであろう「AutoShorts×Remotion」型の新OSS

- Remotion本体とEditor Starterのメジャーアップデート(特にAI連携機能の公式サポート動向)

- YouTube側のショート動画仕様・API仕様の変更(特に自動生成コンテンツの扱い)

---

総じて、現時点での「最適解」は、**1つの完璧なリポジトリを探すのではなく、「ChatGPT Video Generator+podcast-to-video-remotion+AutoShorts的設計+(必要ならEditor Starter)」の組み合わせで、自分専用のRemotion×LLM×音声AIスタックを組み上げること**です。

もし次のステップとして「どの順番でコードを読み始めるか」「最初に作るPoCの具体像」を詰めたい場合は、想定しているチャンネルのジャンル(ニュース系/教育系/娯楽系など)を教えてもらえれば、そのジャンル専用に、より具体的なパイプライン案を組み立てられます。

📚 参考文献

参考文献の詳細は、ブラウザでページを表示してご確認ください。