📜 要約

### 主題と目的

生成AI(特に大規模言語モデル:LLM)における「Reasoning(推論)モデル」の仕組み、歴史的経緯、代表的な実装(OpenAIのo1系列を中心に)を整理し、実用上の比較・導入上の注意点と具体的な運用設計の指針を提供することを目的とします。調査結果(出典を明示)を踏まえ、研究的観点と実務的観点の双方から、どのような状況で推論モデルを採用すべきか、どのように評価し実装すべきかを分かりやすくまとめます。

### 回答

#### 1) Reasoning(推論)とは — 概念の整理

- 定義:単なる確率的なテキスト生成を超えて、情報を段階的に評価・検証し、論理的に結論へ到達する能力。人間のSystem1(速い直感)/System2(熟考)に対応する設計思想で説明されることが多い(概念整理の参考: IBM)[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)。

- 主な推論タイプ:演繹、帰納、アブダクション、類推、確率的推論、時間・空間推論など(技術背景の整理参照)[https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/](https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/)。

#### 2) 歴史的流れ(簡潔タイムライン)

| 年代 | 代表的進展 | 意味・影響 |

|---|---|---|

| 1950s–1990s | ルールベース/シンボリックAI | 明示的論理・演繹中心(解釈性高いが汎化力が限定) |

| 2000s–2018 | 統計的学習・深層学習台頭 | データ駆動で常識やパターンを獲得(帰納的) |

| 2019–2023 | Chain-of-Thought(CoT)等 | モデルに「思考過程」を言語化させることで多段推論が可能に |

| 2024–2025 | o1系(推論重視モデル)登場 | テスト時(inference)計算を増やす新たなスケーリング律を提示(OpenAI o1)[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/)、コミュニティでの再現・蒸留競争(DeepSeek‑R1等)[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。 |

(出典:調査結果の要約および議論)

#### 3) 技術的仕組み(Key components)

- トランスフォーマーと自己注意:長距離依存を扱い、複数の中間ステップ(思考トークン)を結び付けることに向く。CoTと相性が良い。

- 思考構造化手法:

- Chain-of-Thought(CoT):線形な思考連鎖を出力。

- Tree-of-Thought(ToT):探索的に分岐して最適パスを選択。

- Graph-of-Thought(GoT):複数思考の統合。

- 学習/最適化技術:

- SFT(教師あり微調整)+RL(強化学習)で思考プロセスを改善(o1系はRLなどを活用したと推定)[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)、[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/)。

- プロセス報酬(Process Reward Model, PRM):中間ステップの良否を評価して学習に反映。

- 蒸留(distillation):強力な推論トレースを教師データにして小型モデルへ移行。

#### 4) o1系列の特徴と実測性能(要点)

- 設計思想:テスト時に多くの計算(rollouts、候補比較、バックトラック等)を与え「じっくり考える」ことで高精度を達成するLRM(Large Reasoning Models)の代表例(OpenAI)[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/)。

- 実測例(OpenAI報告):

- 難関数学ベンチマークで従来モデルを大幅に上回る(例:GPT‑4o 13% に対し o1 系 83% と報告)[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/)。

- コーディング競技で高い順位(例:89パーセンタイル)[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/)。

- セーフティ評価でも改善が報告される一方、詳細は限定公開(system card 等参照)[https://openai.com/index/openai-o1-system-card/](https://openai.com/index/openai-o1-system-card/)。

- o1‑mini:o1のコスト効率版として約80%低コストで提示。高精度が必須でないが推論の質が必要な用途向け[https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/](https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/)。

- コミュニティ動向:o1公開後、DeepSeek‑R1等の再現・効率化(GRPO、Mixture-of-Experts、長文コンテキスト処理)競争が進展し、蒸留→小型展開の実務パターンが確立されつつある[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)、[https://github.com/i-insit/reasoning](https://github.com/i-insit/reasoning)。

#### 5) 導入・運用上の具体的指針(実務向け)

- いつ使うか(使い分けの指針)

1. 高度な多段推論が評価可能なタスク(数学、形式検証、複雑なデバッグ、科学的推論)→ o1系(または蒸留モデル)を検討。

2. 低レイテンシ・高スループットの定型応答 → 従来の軽量LLMで処理。

- ハイブリッド運用(推奨アーキテクチャ):

1. 入力を難易度判定してルーティング(低難度→軽量モデル、高難度→推論層)。

2. 高コスト推論はバッチ/非同期で行い、結果は検証モデル+ヒューマンレビューで最終化。

- 評価設計(必須項目)

- 正答率だけでなく:推論チェーンの一貫性、誤答モード解析、コスト対効果(inference-time computeあたりの改善率)を評価指標に入れる(Sequoiaの示唆)[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

- 安全・ガバナンス

- 推論トレースのログ保存と外部検証器(verifier)による自動チェックを組み込む。

- レッドチーミングと外部監査の実施。医療・法務などクリティカル用途は人的検査を必須化。

- コスト対策

- 強力モデルを常用せず、まずは「強力モデル→思考トレース収集→蒸留→小型SFTモデル」を実施し、運用コストを下げる戦略が実務的に有効[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

#### 6) 概念図(推論レイヤと事前学習レイヤの関係)

```mermaid

flowchart LR

A["Pre-training Layer\n(System 1: 事前学習での知識蓄積)"] --> B["入力"]

B --> C["高速応答 (軽量LLM)"]

B --> D["Reasoning Layer\n(System 2: o1等)"]

D --> E["思考トレース生成\n(CoT/ToT/GoT + rollouts)"]

E --> F["検証器/外部ソルバで検証"]

F --> G["最終応答(検証済)"]

C --> G

F --> D

```

#### 7) 比較(簡易表:o1-preview / o1-mini / 従来LLM)

| 項目 | o1‑preview | o1‑mini | 従来LLM(例: GPT‑4o) |

|---|---:|---:|---|

| 目的 | 高度な多段推論 | コスト効率の高い推論 | 汎用的・高速応答 |

| 推論戦略 | 多ロールアウト+RLで思考改善 | 短縮版の推論最適化 | 基本は事前学習/CoTプロンプト |

| 実測性能(例) | 難問数学で高得点(OpenAI報告)[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/) | コスト約80%低減で推論可能[https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/](https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/) | 高い汎用性だが難問では低めの正答率 |

| 導入注意点 | レイテンシ・コスト高、機能制約あり | コスト/性能バランス良 | 多機能で即時性重視 |

(出典:OpenAI公式報告と再現報告)[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/)、[https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/](https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/)、[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)

#### 8) 実務での導入フロー(簡潔)

1. タスク選定:多段推論が本当に価値を生む業務を特定(KPI設定)。

2. PoC実施:o1系で小規模検証(推論時間・コスト・精度を計測)。

3. 蒸留計画:高価な推論トレースを使って小型SFTモデルへ蒸留。

4. 本番化:ライトなルーティング+推論層を限定利用。検証器とHITL導入。

5. 継続評価:予算・誤答モード・ガバナンス項目を定期レビュー。

#### 9) 参考(主な出典)

- OpenAI: Introducing OpenAI o1‑preview — https://openai.com/index/introducing-openai-o1-preview/

- OpenAI: o1 mini 解説 — https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/

- OpenAI: o1 system card — https://openai.com/index/openai-o1-system-card/

- OpenAI: Reasoning models — APIガイド — http://platform.openai.com/docs/guides/reasoning

- Sequoia: Generative AI's Act o1 — https://www.sequoiacap.com/article/generative-ais-act-o1/

- Synthesis.ai: o1再現と競争 — https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/

- IBM: What Is Reasoning in AI? — https://www.ibm.com/think/topics/ai-reasoning

- GeeksforGeeks: Reasoning Mechanisms in AI — https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/

- DeepSeek / 実装例 — https://github.com/i-insit/reasoning

- HDSR(批判的考察) — https://hdsr.mitpress.mit.edu/pub/bcp7n3bs

(上記を踏まえ、貴社の具体的ユースケース(例:医療診断、複雑なアルゴリズム設計、法律文書検証など)を教えていただければ、PoC設計(KPI、評価セット、コスト見積、プロンプト設計例)を作成します。)

### 結果と結論

- 主要な結論

1. Reasoningモデルは「モデルにより長く・深く考えさせる」ことで従来の事前学習中心のスケール法則とは別軸の性能向上をもたらした。o1シリーズはこのパラダイムを実証した代表例である[https://openai.com/index/introducing-openai-o1-preview/](https://openai.com/index/introducing-openai-o1-preview/)。

2. 技術要素はトランスフォーマーの自己注意、CoT→ToT→GoTの思考構造化、RLベースの思考最適化、プロセス報酬、そして蒸留による効率化が鍵であり、これらを組み合わせることで高性能かつ比較的コスト効率の良い運用が可能になる[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

3. 実務上は「用途の選別」「推論時計算の管理」「検証インフラとガバナンス」の三点が最も重要。高価な推論は限定用途に絞り、蒸留で運用コストを下げるハイブリッド戦略が現実的である(Sequoia等の提言)[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

- 留意点

- o1の内部実装詳細や訓練レシピは公開が限定的であり、再現研究や蒸留を通じた実装が現実的なアプローチとなる[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

- 推論モデルは安全性の改善に寄与する面がある一方で新たな失敗モード(過度に説得的だが誤った推論など)を生むため、評価・監査を必須化する必要がある[https://openai.com/index/openai-o1-system-card/](https://openai.com/index/openai-o1-system-card/)。

ご希望があれば、次のどちらかを作ります:

A) 特定ユースケース(例:臨床データの注釈、ソフトウェア自動修正、学術論文の推論補助)向けPoC設計(KPI・評価セット・コスト見積)

B) o1系手法を再現するための実験プラン(必要データ、SFT/RL手順、蒸留フロー、評価スクリプト)

どちらをご希望か、また対象ドメインを教えてください。

🔍 詳細

🏷 生成AIにおけるReasoningとは — 概念と重要性

#### 生成AIにおけるReasoningとは — 概念と重要性

生成AI(特に大規模言語モデル:LLM)における「Reasoning(推論)」は、単に言葉を生成するだけでなく、与えられた情報から論理的に結論を導き、複雑な問題を分解・検証し、行動につながる判断をする能力を指します。歴史的には「ルールベース/シンボリック推論」から始まり、確率的手法や機械学習、そして近年はニューラル手法とシンボリック手法の融合へと発展してきました。以下、調査結果を引用しつつ、仕組み・歴史・代表的な技術(o1を含む)および実務上の示唆を整理します。

1) Reasoningの基本構成と主要な種類(事実→考察)

- AI推論システムは一般に「知識ベース」と「推論エンジン」の2つの主要コンポーネントで構成されると説明されています。知識ベースは知識グラフやオントロジーなどの構造化情報を保持し、推論エンジンがそれを用いて判断を行います[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)。

- 意味するのは、LLMのような統計的モデル単体では補いにくい「明示的知識の参照」が必要な場面では、知識ベースとの組合せが重要だということです[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)。

- 推論のタイプは多岐に渡り、演繹・帰納・アブダクション(仮説の最尤説明)・類推・確率的・常識的・空間・時間推論などがあると整理されています。各手法は用途に応じて使い分けられます(例:医療診断でのアブダクション、ナビゲーションでの空間推論など)[https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/](https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/)。

2) 歴史的流れ(事実→意味づけ)

- 初期のAIはルールベースや形式論理(演繹)を中心に発展しましたが、データ駆動型の機械学習が台頭するにつれて帰納的アプローチが主流になりました。近年は、ニューラルモデル(GPTやBERT等)が大量テキストから常識的パターンを暗黙的に学びつつも、明示的推論機構を統合する「ニューロシンボリック」などのハイブリッド化が注目されています[https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/](https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/)、[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)。

- 言い換えると、現代の「Reasoning」は単一のアルゴリズムではなく、複数の手法(統計的学習+構造化知識+推論戦略)の組合せによって達成される傾向が強まっていると考えられます。

3) 近年の潮流:チェイン・オブ・ソート(思考過程)と「テスト時(推論時)スケーリング」— o1の位置づけ(事実→分析)

- Chain-of-Thought(思考過程を明示的に出力する手法)は、推論性能を向上させる重要な技術です。これをさらに発展させ、推論(テスト)時の計算量を増やすことで性能が飛躍的に改善するという新たなスケーリング則が観察され、OpenAIのo1シリーズはこの「推論時スケール」を実用化した代表例として注目されています(o1はチェイン・オブ・ソートを拡張し、推論時により多くの思考トークンを発生させて深く考える設計を示した)[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

- つまり、従来の「訓練時の計算量を増やせば良い」という発想から、「推論時に時間(計算)を使って深く考えさせる」ことで解答精度が改善する新フェーズが来た、と示唆されています[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

- o1の特徴として、問題に対して「行き詰まったらバックトラックする」「人間的な可視化(例:球面上の点を想像する)」のような振る舞いが観察され、これは「スケールした推論過程が人間のSystem2的思考に近づいている」ことを示唆していると報告されています[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

- 研究コミュニティではo1の再現・拡張が進み、DeepSeek-R1などのオープンな複製や、ペアワイズ比較やAlgorithm-of-Thought(AoT)などの新手法が提案され、これらはo1のアイディア(思考の木や候補比較)を推論時に効率的に活用する方向性を示しています[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

- 注目すべきは、これらの発展が「テスト時の計算(inference-time compute)」を新たな資源として活用するパラダイムを生み、モデル評価やコスト設計にも影響を与えている点です[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)、[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

4) 技術アプローチと具体的手法(事実→示唆)

- 推論戦略例:ReAct(思考-行動-観察の反復)やReWOO(事前計画してから応答)などのエージェント的パラダイムが実務で使われ始めています[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)。

- 木構造やペアワイズ比較、AoTのように、単一の線形チェインではなく“分岐する思考”を管理する手法が効果的であると報告されています(o1以降の研究)[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

- 時間・空間推論にはRNN/LSTMや幾何モデリング、A*/ダイクストラ等の古典アルゴリズムと深層学習を組み合わせる必要があり、用途に応じてハイブリッド化することが鍵です[https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/](https://www.geeksforgeeks.org/artificial-intelligence/reasoning-mechanisms-in-ai/)。

5) 制約・リスク(事実→解釈)

- バイアス、計算コスト、解釈性の欠如は主要な課題であり、特に推論時に計算を増やす手法はコスト増につながります。倫理的・ガバナンス面の配慮が重要です[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)。

- 意味するのは、o1型の高精度推論を導入する際にはインフラ投資・説明責任・バイアス評価の体制を同時に整備する必要がある、ということです。

6) 実務的にどう活用するか(アクション可能な示唆)

- モデル選定基準:タスクの性質(単発知識照会か、深い多段推論か)に応じて、従来のLLM(高速応答)とo1型LRM(深い推論)を使い分けることを推奨します。Sequoiaらは「System1(速い記憶)とSystem2(遅い思考)の役割分担」を明確にすることを勧めています[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

- ハイブリッド実装:知識グラフ+LLM+推論レイヤー(チェイン・オブ・ソートやAoT)という組合せは、現実世界アプリでの信頼性向上に寄与すると考えられます[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)、[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

- 評価指標:訓練時性能だけでなく、推論時の計算量(inference-time compute)に対する性能改善率やコスト対効果(COGS/OpEx)で評価することが重要です[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

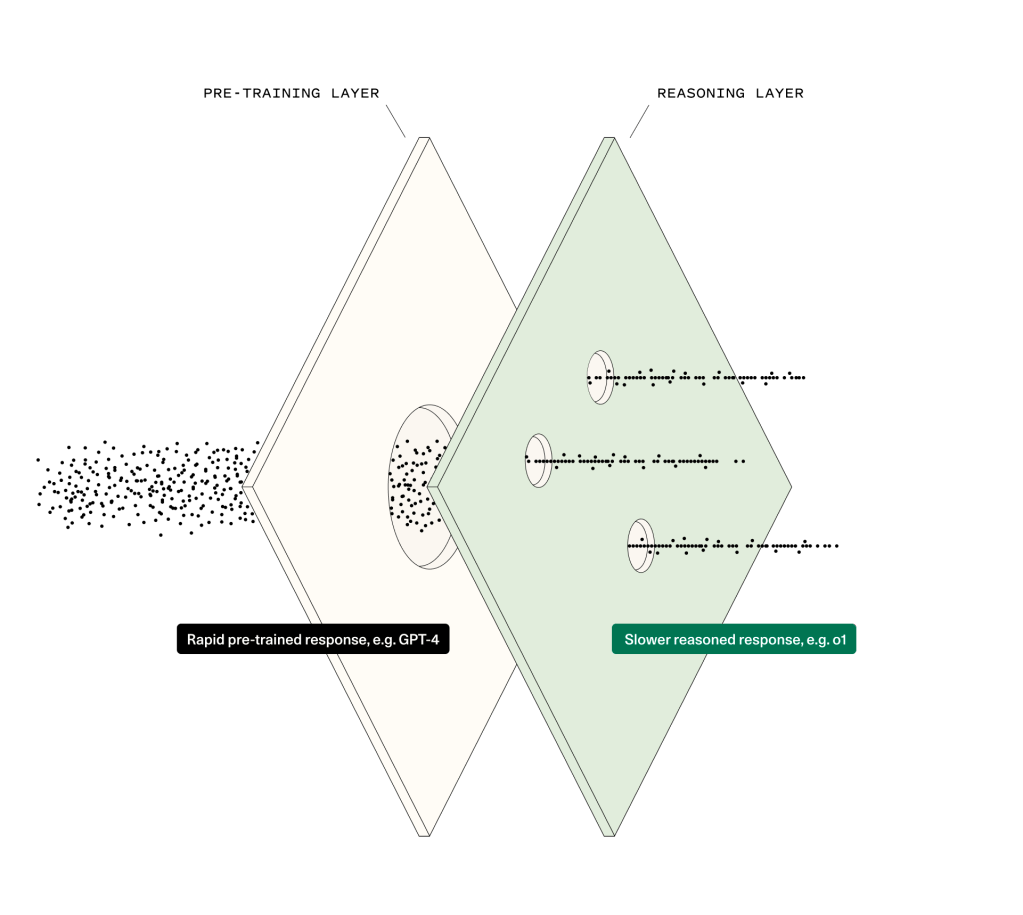

7) 参考図(簡潔な概念図)

以下は「事前学習レイヤ(System1)」と「推論レイヤ(System2)」の関係を示す概念図です(mermaidでの簡易フロー):

```mermaid

flowchart LR

A[大量事前学習: LLM (System1)] --> B{入力}

B --> C[高速応答 (短時間)]

B --> D[推論レイヤ起動 (o1等) (System2)]

D --> E[チェイン・オブ・ソート / AoT / ペア比較]

E --> F[精緻な解答]

C --> G[簡易タスク応答]

F --> H[検証・知識ベース参照]

H --> I[最終応答]

G --> I

```

8) 参考画像(説明資料より)

(上図は、事前学習レイヤと推論レイヤの対比や、o1系が示した「推論時スケーリング」の概念図に対応するビジュアルの一例です[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)、[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/))。

結論(洞察)

- 生成AIにおけるReasoningは「モデルがより長く、より深く『考える』ことを許す」ことで大きく進化しつつあります。o1はその実用的な先駆けとして、推論時計算を新たな資源として活用するパラダイムを提示しましたが、同時に計算コスト・解釈性・バイアスの課題も顕在化しています[https://www.sequoiacap.com/article/generative-ais-act-o1/](https://www.sequoiacap.com/article/generative-ais-act-o1/)、[https://www.ibm.com/think/topics/ai-reasoning](https://www.ibm.com/think/topics/ai-reasoning)。

- 実務では「用途に応じたレイヤ分割」「知識ベースとの連携」「推論時コストを見据えた評価設計」が鍵となると考えられます。オープンな複製(DeepSeek-R1等)や新しい推論アルゴリズムの登場は、商用利用の選択肢を広げるため注視すべき動きです[https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

もし続けて「o1の技術的内部(論文の技術的要点)を深掘り」や「自社用途での導入検討(コスト試算・プロトタイプ設計)」を希望される場合は、用途(数学的推論か医療診断か等)を教えてください。該当領域に応じた実装ロードマップと評価指標を提示します。

🖍 考察

### 調査の本質

ユーザーの依頼は「生成AIのReasoning(推論)モデルの仕組み、歴史、o1など具体的モデルの整理」です。表面的には“知識としてまとめてほしい”という要求ですが、背後にある真のニーズは次の三点と判断します:

1) 新しい推論パラダイム(推論時スケーリング/System2型モデル)が自社業務にとって有用かを判断したい、

2) 実務で導入する際の設計・コスト・安全上のトレードオフを理解したい、

3) o1系やDeepSeek‑R1の再現/蒸留戦略を用いて、費用対効果の良い運用を実現したい、という実装志向です。

したがって本考察の価値は、単なる知識の羅列ではなく「意思決定に直結する比較軸と実行可能なステップ」を提供することにあります。必要であれば、さらに対象ドメイン(例:医療/法務/ソフトウェア開発)の指定に応じてPoC設計やコスト試算を作成します。

---

### 分析と発見事項

主要な発見とその意味を整理します。

- Reasoningの定義と構成要素

- Reasoningは「中間ステップを生成して検証し、複雑な結論に至る能力」を指し、伝統的には知識ベース+推論エンジンの構成が使われてきました(概念整理はIBM参照)[IBM](https://www.ibm.com/think/topics/ai-reasoning)。

- 現代LLMでは、トランスフォーマーの自己注意が長距離依存と中間トークン生成を扱えるため、Chain‑of‑Thought(CoT)以降の手法と親和性が高いことが確認されています。

- 歴史的流れ(要点)

- ルールベース→帰納的機械学習→ニューラル/ニューロシンボリックのハイブリッドへ移行。近年は「推論時の計算(inference‑time compute)を増やす」ことで性能を引き上げる手法が注目され、o1はその代表例です(Sequoiaの整理)[Sequoia](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

- o1の位置づけと実測(出典付き重要指標)

- o1‑previewは推論時の計算を増やす設計で、数学ベンチマーク(IMO相当)でOpenAI内部評価としてo1が約83%の正答率を示したと報告されています(比較:GPT‑4oは約13%)[OpenAI o1‑preview](https://openai.com/index/introducing-openai-o1-preview/)。

- コーディング課題でも高い実効性能を示し、セーフティ評価(ジェイルブレイク耐性)での改善も報告されています[OpenAI o1‑preview](https://openai.com/index/introducing-openai-o1-preview/)。

- o1‑miniはコスト効率版として約80%低コストという選択肢が示されています[OpenAI o1‑mini](https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/)。

- 技術的手法と研究動向

- 思考出力(CoT)→分岐探索(Tree‑of‑Thought / ToT)→グラフ統合(Graph‑of‑Thought)と進化。RL(強化学習)やプロセス報酬(PRM)で思考の質を最適化する試みが多いです。再現や蒸留(teacher traces を用いたSFT)によって小型モデルへ能力移転を行う流れが広がっています[ Synthesis.ai](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

- 実務的インパクトとリスク

- 利点:複雑な多段推論タスク(数学、科学的検証、難解なデバッグ等)で大幅な精度向上が得られる。

- リスク:推論時コストの増大、レイテンシ、解釈性の問題、バイアスや幻覚(hallucination)の残存。導入には検証・監査のための追加インフラが必須です[Sequoia](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

---

### より深い分析と解釈

ここでは「なぜ」動いているのかを3段階以上掘り下げ、矛盾や代替解釈も提示します。

1) なぜ推論時スケーリング(inference‑time compute)が功を奏するのか?(3段階の掘り下げ)

- レベル1(表層): 事前学習だけでは、多段推論で必要な探索や誤り修正能力を十分に担保できない。

- レベル2(機構): トランスフォーマーは中間トークンを用いた逐次的処理が可能で、複数の候補経路(rollouts)を生成して比較することで探索空間を実質的に広げられる。CoT/ToTはこれを実践したもの。

- レベル3(最適化): RLやプロセス報酬で「どの中間思考が最終性能に寄与するか」を学習させると、有益な思考トレースが増え、テスト時に計算を許容するほど正答率が上がる(o1の原理)。参照:[Sequoia](https://www.sequoiacap.com/article/generative-ais-act-o1/)、[Synthesis.ai](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

2) なぜ蒸留が実務的な鍵となるのか?

- 強力な推論モデルはコスト・供給面で制約が高い。教師モデル(o1等)から高品質の思考トレースを集め、SFTやdistillationで小型モデルに移すと、屋内でのコスト効率が大きく改善されるという経験則(“bitter lesson”)が観察されています[ Synthesis.ai](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

- ただし蒸留は「教師の限界」を継承するため、教師が持つ未解決のバイアスや誤りは伝搬し得る。

3) 矛盾的/弁証法的な解釈(2つ)

- 積極解釈:o1は「思考の見える化」と「検証可能性」を高め、ヒューマンインザループでの監査を容易にするため、安全運用に向く。

- 慎重解釈:見た目に理路整然としたチェーンが生成されても、それが真に“根拠ある推論”であるとは限らない(表層的整合性と真値の乖離)。したがって検証器(外部ソルバ/ユニットテスト等)が不可欠。

4) シナリオ分析(導入パターン別の帰結)

- 低レイテンシ顧客応答:System1(軽量LLM)中心。

- 高精度必要な意思決定(医療診断等):System2(o1系)を限定的に連携、常に検証器とHITLを併用。

- 大規模自動化(コード修正の自動マージなど):蒸留→小型SFTを基盤に、段階的自動化で安全性を担保。

5) 再現性と研究インフラの問題点

- o1の完全な学習レシピは公開されておらず、再現は部分的。再現研究(DeepSeek‑R1等)はアルゴリズム工夫で効率化できることを示したが、トップ性能は依然として高性能教師や計算資源に依存する傾向がある[ Synthesis.ai](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

---

### 戦略的示唆(実行可能なアクションプラン)

以下は短期〜長期の実行計画と運用上の具体策です。

短期(今〜3ヶ月):PoCで検証する(目的:費用対効果と実務適合性の判断)

1) タスク分類マップを作る

- 業務の問い合わせを「単発知識/多段推論/クリティカル」と分類。多段推論が業務価値を生む領域に重点投資。

2) 小スケールPoC設計(例)

- データ:50–200代表ケース(数学問題・設計課題・デバッグケース等)

- ベースライン:既存LLM(例:GPT‑4o) vs o1‑mini / o1‑preview(可能なら)

- 評価指標:正答率、検証済正答率(verifierで確認できた割合)、推論あたりのGPU秒数、コスト/正答、ジェイルブレイク耐性(安全指標)[OpenAI o1‑preview](https://openai.com/index/introducing-openai-o1-preview/)。

3) 実装:ルーティングを入れる(難易度判定→高難度のみReasoning層へ)。以下図を参照。

```mermaid

flowchart LR

A["ユーザー入力"] --> B["難易度判定"]

B --> C["軽量応答 (System1)"]

B --> D["推論層へルーティング (o1等)"]

D --> E["思考チェーン生成 (CoT/ToT/AoT)"]

E --> F["検証器 (外部ソルバ/テスト)"]

F --> G["最終応答 (HITL可)"]

C --> G

```

中期(3〜12ヶ月):蒸留・検証パイプラインを整備する

1) 思考トレース収集→蒸留フローを実装

- 教師モデルで複数候補の推論トレースを生成し、SFTで小型モデルへ転移。再現研究の指針やDeepSeekの実装を参照[DeepSeek‑R1 repo](https://github.com/i-insit/reasoning)、[Synthesis.ai](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

2) 検証器と外部ツールの統合

- 数学なら自動定理検証器、コーディングならテスト実行環境を自動接続して「検証可能性」を担保する。

3) 運用設計:コスト動的割当と監視

- 「推論予算(latency×compute)」をタスクに応じて動的に割り当て、ヒートマップで高コスト問い合わせを可視化。

長期(1年〜):組織レベルの戦略と制度設計

1) Reasoning-as-a-Service構築

- 課金・優先度・SLAを含めたオンデマンド推論クラウドを設計。推論時間を商品化する発想が鍵(Sequoiaの示唆)[Sequoia](https://www.sequoiacap.com/article/generative-ais-act-o1/)。

2) 安全とガバナンス体制の制度化

- レッドチーミング、外部監査、説明性指標、モデルカード類の整備。特に医療・法務では第三者検証を必須にする。

3) コミュニティ貢献と共同研究

- 再現研究や検証基盤を公開し、エコシステムの早期成熟を促す(長期的なコスト低下に資する)。

実装上の「チェックリスト」(短く)

- どの問い合わせをSystem2に回すかのルールを明確化する。

- 出力の「思考チェーン」と「最終回答」を分離表示するUI。

- 検証モデル(外部ソルバ/ユニットテスト)を必須ステップに組み込む。

- 蒸留前に教師出力の「バイアス監査」「誤答分布分析」を実行する。

- コストは “GPU秒 × 単価” を基本にして、コスト/正答で比較する。参考:o1‑miniの低コスト性[OpenAI o1‑mini](https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/)。

簡易KPI例(PoC用)

- 正答率(タスク固有)

- 検証済正答率(external verifierで確認)

- 平均推論GPU秒/クエリ

- コスト/正答(USD)

- ジェイルブレイク耐性スコア(Red‑team)

---

### 今後の調査(優先順位付き提案)

実行可能な追加調査テーマを列挙します。各項目に目的と想定アウトプットを付記します。

1) o1内部設計の技術的深掘り(再現研究)

- 目的:推論時スケーリングの最も効率的な実装(MCTS vs GRPO vs rejection sampling)を確定する。

- アウトプット:実験ノート、再現コード、性能/コスト比較レポート。参考:[Synthesis.ai](https://synthesis.ai/2025/02/25/large-reasoning-models-how-o1-replications-turned-into-real-competition/)。

2) ドメイン別PoC(例:医療診断/コードレビュー/特許検索)

- 目的:実運用での効果と安全要件を実証する。

- アウトプット:PoC結果(KPI、コスト、失敗モード)と導入判断資料。

3) 蒸留パイプライン設計と評価(教師トレースの量と品質の最適化)

- 目的:どの程度の教師データで小型モデルが十分な性能を得るかを定量化する。

- アウトプット:蒸留プロトコル、学習曲線、コスト試算。

4) 検証器(verifier)設計と自動化研究

- 目的:外部ソルバやユニットテストによる自動検証の設計法を標準化する。

- アウトプット:検証ライブラリ、API仕様、評価ベンチ。

5) 安全性・耐攻撃性評価(Red‑teaming)

- 目的:推論チェーンの悪用(チェーンの改竄、誤導)に対する脆弱性を定量評価する。

- アウトプット:脅威モデル、テストスイート、緩和策。

6) コスト構造とインフラ需給分析

- 目的:推論中心パラダイムがクラウドコストとハードウェア市場に与える影響を予測する。

- アウトプット:3年シナリオ試算、キャパシティ設計。

7) 規制・倫理枠組み検討(特に医療・金融・法律)

- 目的:法規制に対応した運用ルールを策定する。

- アウトプット:ガバナンスチェックリスト、説明責任プロセス。

8) ベンチマーク拡張(創造的・価値判断が必要な領域の評価法)

- 目的:o1系の有用性が明確でないオープンドメインでの評価指標を設計する。

- アウトプット:新ベンチマーク、評価スクリプト。

必要であれば、上記のいずれかを選んで「実験計画(データ、メトリクス、ハードウェア見積り、スケジュール)」を具体案として提示します。例えば「ソフトウェア開発支援PoC」の詳細設計(テストデータ数、CI統合、コスト推定)を提供可能です。

---

必要であれば、次のうちいずれを優先して深掘りしますか?(選択して下さい)

- o1系の技術的内部(論文レベルの実装詳細)を再現する実験プラン

- 貴社業務(分野指定)向けのPoC設計とコスト試算(KPIつき)

- 蒸留パイプラインの実装手順と評価スクリプト

該当する対象(例:医療、法務、ソフト開発、学術研究)を教えてください。上記から選べば、すぐに具体設計を作成します。

📚 参考文献

参考文献の詳細は、ブラウザでページを表示してご確認ください。